一文读懂液冷技术在智算中心与超算中心的发展应用

日期:2024年04月23日 | 浏览次数:19682

科技发展时代,液冷正日益成为数据中心建设和应用的关键引擎。

01

液冷加持

液冷智算中心特点

图源:国务院政策文件

目前,各地政府,工业信息化、发展改革委员会等部门,均对高耗能的数据中心建设行业提出了较高的要求。新建型数据中心多处要求达到年平均PUE<1.25的较高门槛。

液冷智算中心是指以人工智能技术为核心,集成大数据、云计算、物联网等多种技术手段,旨在解决复杂问题和提高决策效率的科研和应用平台。其特点主要包括以下几个方面:

1.液冷智算中心具有强大的数据处理和分析能力。通过大数据技术,智算中心能够快速高效地处理海量数据,挖掘数据背后的价值和规律,为科研和决策提供可靠的数据支持。

2.液冷智算中心拥有先进的人工智能算法和技术。通过机器学习、深度学习等人工智能技术,智算中心能够实现对数据的自动学习和智能分析,提供更精准和高效的解决方案。

3.液冷智算中心具备灵活的计算和资源调度能力。借助云计算和虚拟化技术,智算中心能够根据需求动态调整计算资源,实现资源的合理利用和灵活分配,提高计算效率和性能。

4.液冷智算中心还具有良好的应用开发和服务支持能力。通过构建开放的应用接口和平台,智算中心能够为用户提供丰富多样的应用服务和解决方案,满足不同用户的需求和应用场景。

02

液冷护航

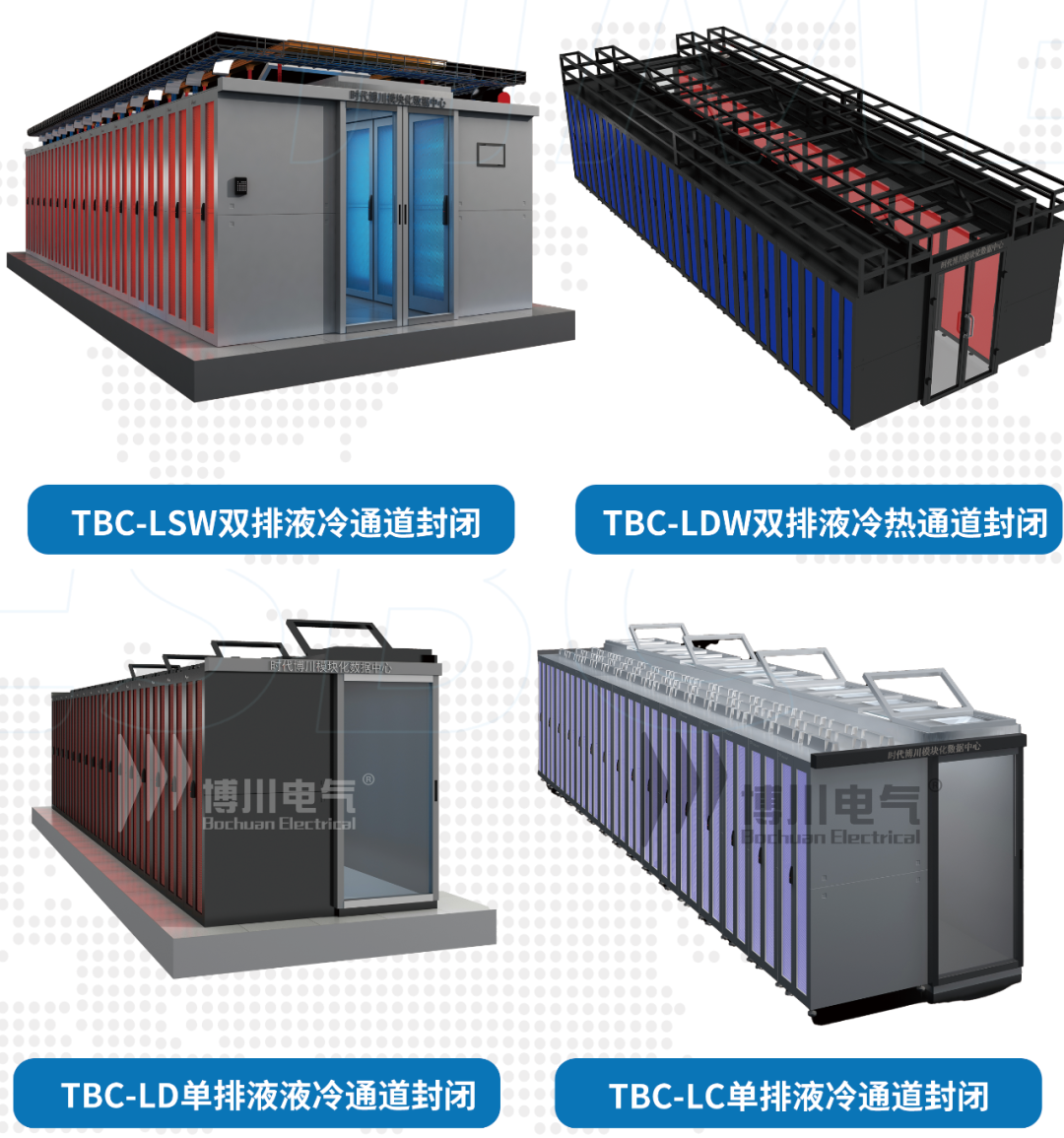

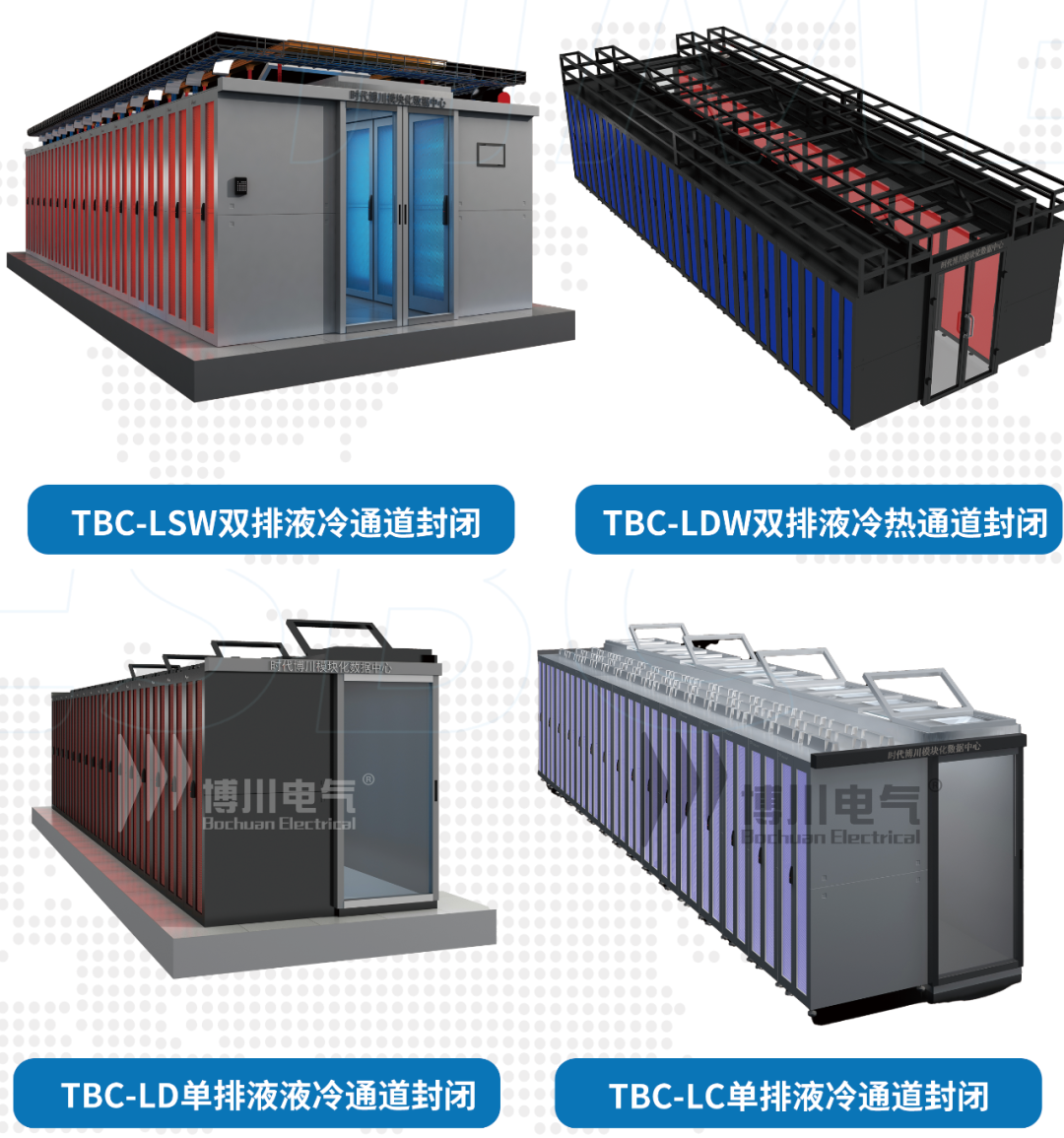

液冷超算中心微模块特点

图源:液冷超算中心微模块密闭通道项目

液冷超算中心是指以高性能计算技术为核心,集成并行计算、分布式计算等多种技术手段,为科学研究和工程计算提供强大支持的科研机构或实验室。其方案特点主要包括以下几个方面:

1.液冷超算中心拥有超强的计算能力和运算速度。通过并行计算和分布式计算技术,超算中心能够实现对复杂问题的快速求解和高效仿真,为科学研究和工程设计提供强大的计算支持。

2.液冷超算中心具备丰富的应用场景和行业应用经验。在科学计算、气象预报、航天航空、生物医学等领域,超算中心已经积累了丰富的应用经验和成功案例,为各行各业提供了重要支持和保障。

3.液冷超算中心还具有高度的安全性和稳定性。通过严格的安全管理和监控机制,超算中心能够保障计算环境的安全性和稳定性,确保计算任务的顺利进行和数据的安全存储。

4.液冷超算中心还具备卓越的科研创新和人才培养能力。作为科研机构或实验室,超算中心致力于开展前沿科学研究和技术创新,培养和吸引了大量的科研人才,为科技创新和人才培养做出了重要贡献。

液冷微模块技术方案特点:

低噪宁静

区别于传统风冷机房,超静音,完美融入办公环境。

可靠需求

液冷微模块产品采用CDU机柜和普通风冷列间空调共用的方式,分别为冷板式液冷服务器和其他IT设备制冷,能够满足高密度、大规模的数据中心制冷需求。

易于选址

不受空气质量与气候影响,不受能源政策限制,全国各地均可部署。

03

液冷智造

液冷智算中心与液冷超算中心的关系

图源:液冷数据中心业务架构图

液冷智算中心和液冷超算中心在技术手段和应用领域上存在一定的联系和互补关系:

1.液冷智算中心和超算中心在数据处理和计算能力方面都具有突出的优势,可以相互借鉴和合作,共同推动科技发展和应用创新。

2.在应用场景上有着一定的重叠和交叉,如智算中心的人工智能算法和技术可以应用于超算中心的科学计算和工程仿真中,而超算中心的高性能计算平台也可以为智算中心的数据处理和分析提供强大的计算支持和基础设施。

3.在人才培养和科研创新方面也存在着一定的联系和互补。智算中心侧重于人工智能和数据分析等领域的研究和应用,需要具备相关技术和领域知识的人才支持;而超算中心则注重高性能计算和科学计算方面的研究和创新,需要具备计算机科学、数学等相关学科的专业人才。因此,液冷智算中心和液冷超算中心可以通过人才培养和科研合作等方式相互支持和互惠互利,共同推动科技创新和人才培养。

液冷技术对于智算中心和超算中心的优势

更低整机功耗:整机关键热源由冷板带走后整机温度下降,从而风扇转速降低,节省服务器整体功耗。

更低CDU功耗:相同热阻下,CDU仅需提供比业界标准更低的流量和流阻即可满足服务器散热需求,从而降低CDU泵转速,节省功耗。

更低机房功耗:冷却塔仅靠自然冷却即可满足一次侧进液温度要求,无需制冷机组,降低机房功耗。

04

液冷装备

液冷技术对未来数据中心发展的影响和作用

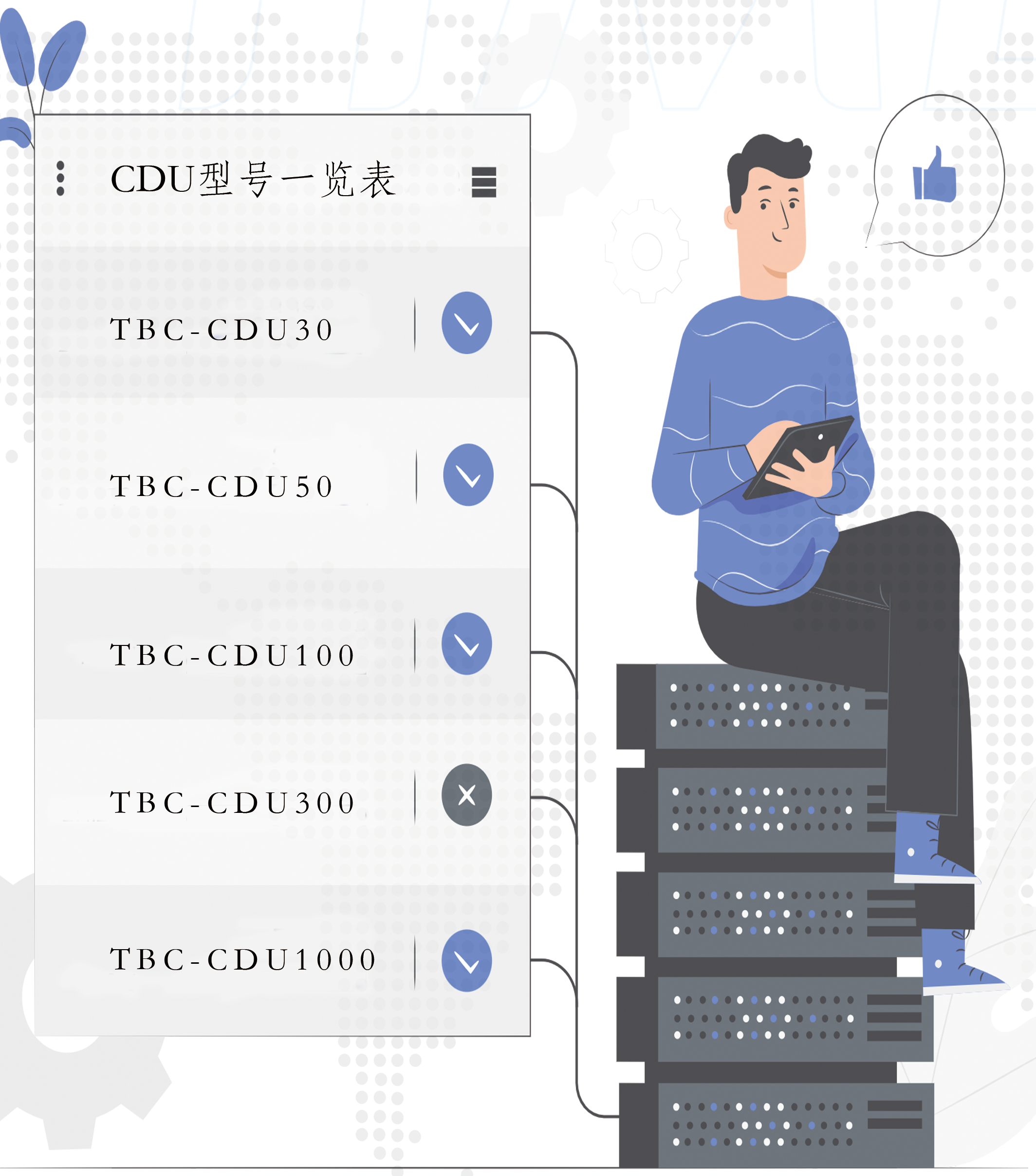

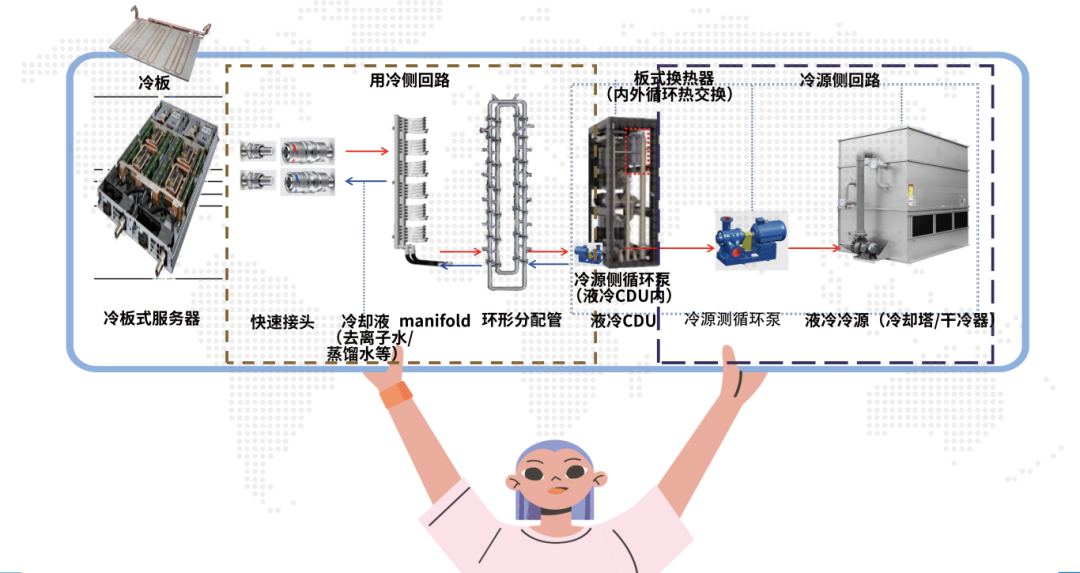

图源:液冷数据中心CDU产品

液冷智算中心和液冷超算中心的发展将对未来科技发展产生深远的影响和作用。

AI带来高算力需求,叠加双碳时代严控PUE,在数据中心高密度化时代,液冷优势日益凸显。

AI集群功率密度较高,单机柜功率不断增长,逼近风冷散热极限,逼近风冷12-15KW散热极限,继续采用风冷散热将导致行间空调需求数量陡增,高密度散热场下液冷方案成本性能优势显著。

在双碳战略引导下,政策对PUE要求趋严,加速推动IDC向低碳化演变,液冷是散热技术演变的必经之路,未来有望成为首选。

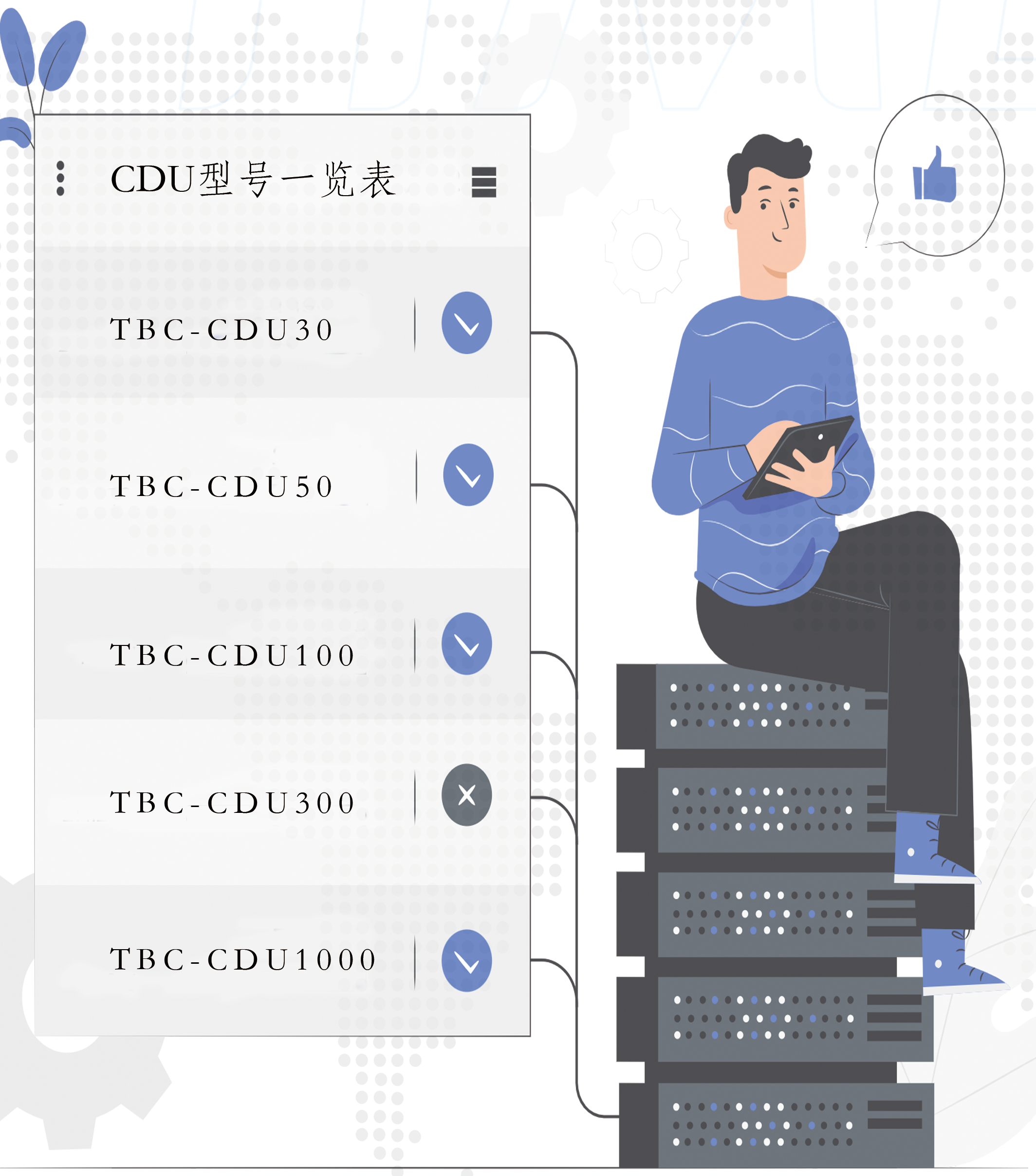

图源:液冷数据中心CDU型号一览表

综上所述,我们不禁要感叹科技的力量,正是这些液冷计算中心的不断发展,让我们的生活变得更加美好,也为我国的科技发展插上了翅膀。让我们期待智算中心和超算中心在未来发挥更大的作用,为人类社会带来更多的惊喜和变革。

科技发展时代,液冷正日益成为数据中心建设和应用的关键引擎。

01

液冷加持

液冷智算中心特点

图源:国务院政策文件

目前,各地政府,工业信息化、发展改革委员会等部门,均对高耗能的数据中心建设行业提出了较高的要求。新建型数据中心多处要求达到年平均PUE<1.25的较高门槛。

液冷智算中心是指以人工智能技术为核心,集成大数据、云计算、物联网等多种技术手段,旨在解决复杂问题和提高决策效率的科研和应用平台。其特点主要包括以下几个方面:

1.液冷智算中心具有强大的数据处理和分析能力。通过大数据技术,智算中心能够快速高效地处理海量数据,挖掘数据背后的价值和规律,为科研和决策提供可靠的数据支持。

2.液冷智算中心拥有先进的人工智能算法和技术。通过机器学习、深度学习等人工智能技术,智算中心能够实现对数据的自动学习和智能分析,提供更精准和高效的解决方案。

3.液冷智算中心具备灵活的计算和资源调度能力。借助云计算和虚拟化技术,智算中心能够根据需求动态调整计算资源,实现资源的合理利用和灵活分配,提高计算效率和性能。

4.液冷智算中心还具有良好的应用开发和服务支持能力。通过构建开放的应用接口和平台,智算中心能够为用户提供丰富多样的应用服务和解决方案,满足不同用户的需求和应用场景。

02

液冷护航

液冷超算中心微模块特点

图源:液冷超算中心微模块密闭通道项目

液冷超算中心是指以高性能计算技术为核心,集成并行计算、分布式计算等多种技术手段,为科学研究和工程计算提供强大支持的科研机构或实验室。其方案特点主要包括以下几个方面:

1.液冷超算中心拥有超强的计算能力和运算速度。通过并行计算和分布式计算技术,超算中心能够实现对复杂问题的快速求解和高效仿真,为科学研究和工程设计提供强大的计算支持。

2.液冷超算中心具备丰富的应用场景和行业应用经验。在科学计算、气象预报、航天航空、生物医学等领域,超算中心已经积累了丰富的应用经验和成功案例,为各行各业提供了重要支持和保障。

3.液冷超算中心还具有高度的安全性和稳定性。通过严格的安全管理和监控机制,超算中心能够保障计算环境的安全性和稳定性,确保计算任务的顺利进行和数据的安全存储。

4.液冷超算中心还具备卓越的科研创新和人才培养能力。作为科研机构或实验室,超算中心致力于开展前沿科学研究和技术创新,培养和吸引了大量的科研人才,为科技创新和人才培养做出了重要贡献。

液冷微模块技术方案特点:

低噪宁静

区别于传统风冷机房,超静音,完美融入办公环境。

可靠需求

液冷微模块产品采用CDU机柜和普通风冷列间空调共用的方式,分别为冷板式液冷服务器和其他IT设备制冷,能够满足高密度、大规模的数据中心制冷需求。

易于选址

不受空气质量与气候影响,不受能源政策限制,全国各地均可部署。

03

液冷智造

液冷智算中心与液冷超算中心的关系

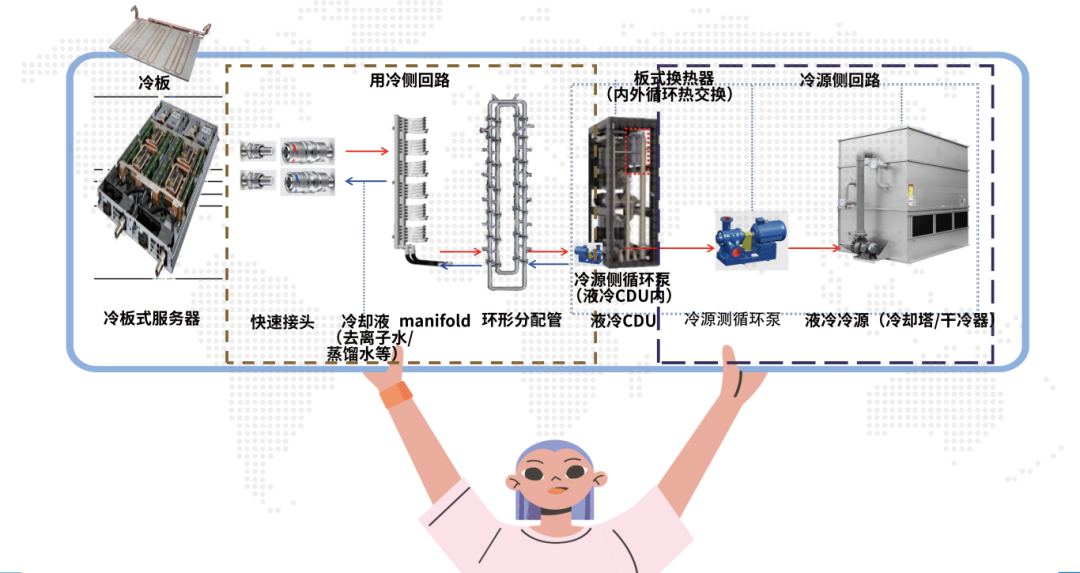

图源:液冷数据中心业务架构图

液冷智算中心和液冷超算中心在技术手段和应用领域上存在一定的联系和互补关系:

1.液冷智算中心和超算中心在数据处理和计算能力方面都具有突出的优势,可以相互借鉴和合作,共同推动科技发展和应用创新。

2.在应用场景上有着一定的重叠和交叉,如智算中心的人工智能算法和技术可以应用于超算中心的科学计算和工程仿真中,而超算中心的高性能计算平台也可以为智算中心的数据处理和分析提供强大的计算支持和基础设施。

3.在人才培养和科研创新方面也存在着一定的联系和互补。智算中心侧重于人工智能和数据分析等领域的研究和应用,需要具备相关技术和领域知识的人才支持;而超算中心则注重高性能计算和科学计算方面的研究和创新,需要具备计算机科学、数学等相关学科的专业人才。因此,液冷智算中心和液冷超算中心可以通过人才培养和科研合作等方式相互支持和互惠互利,共同推动科技创新和人才培养。

液冷技术对于智算中心和超算中心的优势

更低整机功耗:整机关键热源由冷板带走后整机温度下降,从而风扇转速降低,节省服务器整体功耗。

更低CDU功耗:相同热阻下,CDU仅需提供比业界标准更低的流量和流阻即可满足服务器散热需求,从而降低CDU泵转速,节省功耗。

更低机房功耗:冷却塔仅靠自然冷却即可满足一次侧进液温度要求,无需制冷机组,降低机房功耗。

04

液冷装备

液冷技术对未来数据中心发展的影响和作用

图源:液冷数据中心CDU产品

液冷智算中心和液冷超算中心的发展将对未来科技发展产生深远的影响和作用。

AI带来高算力需求,叠加双碳时代严控PUE,在数据中心高密度化时代,液冷优势日益凸显。

AI集群功率密度较高,单机柜功率不断增长,逼近风冷散热极限,逼近风冷12-15KW散热极限,继续采用风冷散热将导致行间空调需求数量陡增,高密度散热场下液冷方案成本性能优势显著。

在双碳战略引导下,政策对PUE要求趋严,加速推动IDC向低碳化演变,液冷是散热技术演变的必经之路,未来有望成为首选。

图源:液冷数据中心CDU型号一览表

综上所述,我们不禁要感叹科技的力量,正是这些液冷计算中心的不断发展,让我们的生活变得更加美好,也为我国的科技发展插上了翅膀。让我们期待智算中心和超算中心在未来发挥更大的作用,为人类社会带来更多的惊喜和变革。